SPONSORED POST

Künstliche Intelligenz (KI) ist längst kein Zukunftsthema mehr – Unternehmen, die KI erfolgreich einführen, sichern sich heute entscheidende Wettbewerbsvorteile. Ob bei der Automatisierung von Prozessen, der Steigerung der Produktivität oder der Beschleunigung von Innovationen: KI verändert die Art und Weise, wie Organisationen arbeiten, Entscheidungen treffen und wachsen.

Doch die Einführung von Künstlicher Intelligenz in Unternehmen bringt komplexe Herausforderungen mit sich. Eine leistungsfähige KI-Infrastruktur ist Voraussetzung, um große Datenmengen effizient zu verarbeiten und den steigenden Anforderungen an Rechenzentrum-Computing, Energieeffizienz und Datenmanagement gerecht zu werden. Gleichzeitig müssen Investitionen strategisch geplant und auf unternehmerische Ziele wie höhere Produktivität und schnellere Innovation ausgerichtet werden.

Wer KI im Unternehmen einführen will, braucht also mehr als nur die richtige Software – es braucht eine moderne, skalierbare Infrastruktur, die Wachstum, Sicherheit und Nachhaltigkeit vereint. Nur so lassen sich Risiken kostspieliger Fehlinvestitionen vermeiden und die vollen Chancen der Künstlichen Intelligenz nutzen.

Die 3 großen Herausforderungen bei der KI-Einführung

Unternehmen stehen bei der Implementierung von KI vor drei primären Hürden:

1. Fehlende KI-Bereitschaft der bestehenden Infrastruktur.

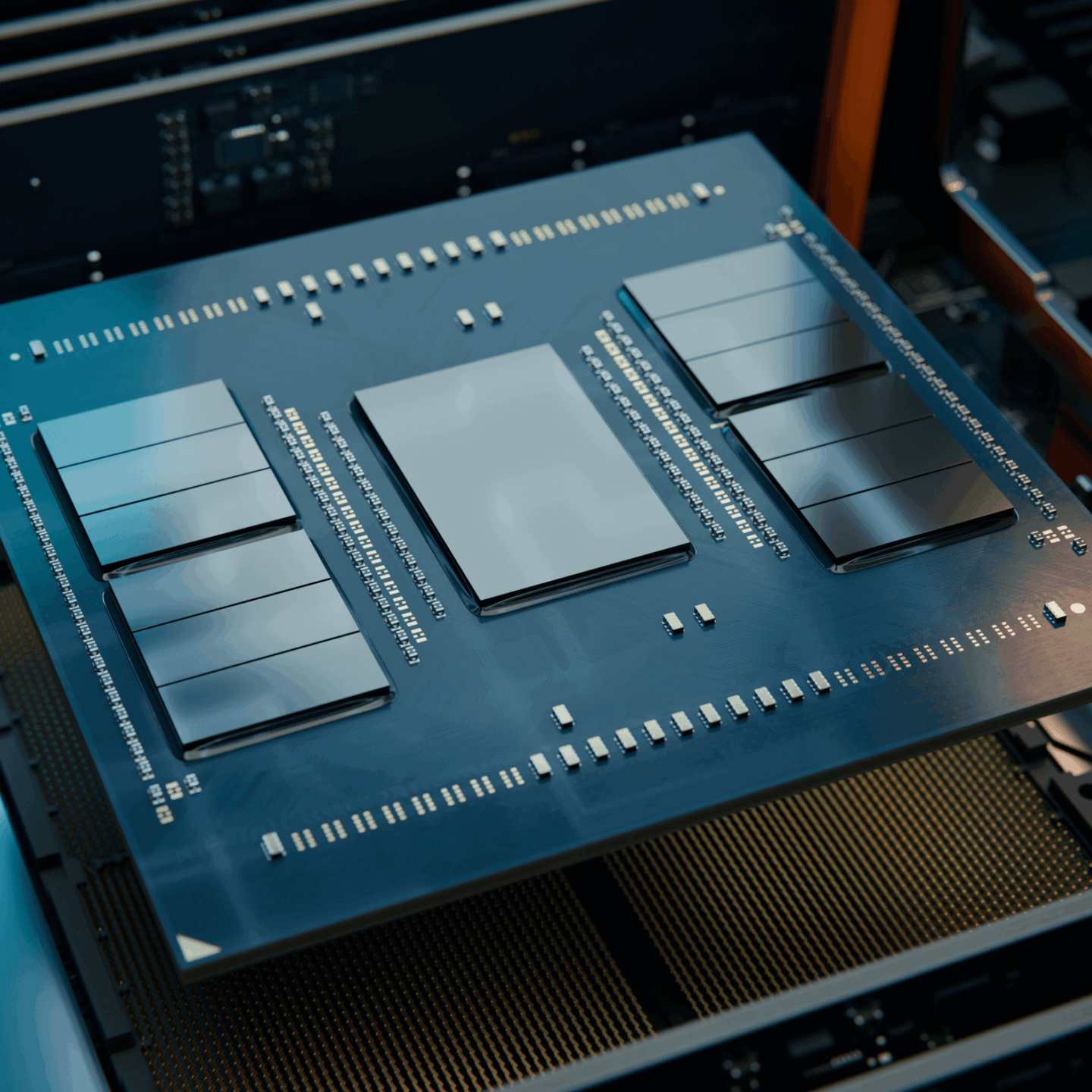

Die begrenzte Leistungsfähigkeit bestehender IT- und Rechenzentrumsinfrastrukturen ist eine der größten Hürden bei der Einführung und Skalierung von Künstlicher Intelligenz (KI) in Unternehmen. KI-Workloads beanspruchen enorme Rechenleistung und führen häufig zu Engpässen, da viele Systeme bereits an der Kapazitätsgrenze arbeiten. Energiebedarf, CPU-Ressourcen sowie Speicher- und Netzwerkbandbreite sind oft vollständig ausgelastet. Die Integration zusätzlicher KI-fähiger Hardware erfordert meist höhere Dichte und mehr Stellfläche, als die vorhandene Rechenzentrumsarchitektur zulässt. Gleichzeitig verursacht die fortlaufende Nutzung veralteter Infrastruktur hohe Opportunitätskosten, da wertvolle Ressourcen gebunden werden, die besser in KI-Innovationen und Effizienzsteigerung investiert wären.

2. KI steigert die Nachfrage nach Confidential Computing.

Angesichts der Tatsache, dass Künstliche Intelligenz (KI) zunehmend zur „Killer-Anwendung“ wird, die nahezu jede Facette geschäftlicher und persönlicher Daten betrifft, ist Vertrauen in die Datensicherheit, Vertraulichkeit und Integrität entscheidend. Gleichzeitig basiert High-Performance-KI auf einer heterogenen KI-Infrastruktur – bestehend aus CPUs, GPUs und spezialisierten Beschleunigern –, die über mehrere Knoten und oft sogar über verschiedene Standorte verteilt ist. Daher müssen Unternehmen Funktionen des Confidential Computing in ihre KI-Workflows integrieren, um sensible Daten auch während der Verarbeitung zu schützen. Dazu gehören etwa sicher verschlüsselte Virtualisierungen, die über Dutzende oder Hunderte von Knoten skalierbar sind und so ein vertrauenswürdiges und sicheres KI-Ausführungsmodell schaffen.

Haben Sie nur wenig Zeit?

Genau für Sie haben wir diesen Blogartikel visuell zusammengefasst.

Blättern Sie jetzt durch die PDF, um schnell zu erfahren, wie Sie Ihr Unternehmen KI-bereit machen.

3. Es ist schwierig, entschlossen zu investieren und gleichzeitig flexibel zu bleiben.

KI-Initiativen lassen sich im Wesentlichen in zwei Kategorien unterteilen: Produktivitätssteigerungen, die durch Automatisierung oder effizientere Workflows erreicht werden, und Innovationen, die neue Umsatzmöglichkeiten erschließen oder bahnbrechende Erkenntnisse ermöglichen. Während produktivitätssteigernde Workloads meist Inferenz-Workloads mit geringeren Trainingsanforderungen darstellen und oft problemlos von der neuesten CPU-Generation verarbeitet werden können, bringen Innovationsprojekte deutlich höhere Trainingsanforderungen mit sich und erfordern daher möglicherweise Investitionen in neue GPU-Ressourcen. Folglich ist ein ausgewogenes Investitionsportfolio, das beide Zielsetzungen berücksichtigt, eine zentrale strategische Herausforderung.

AMD EPYC™ Prozessoren sind die führende CPU für KI

Prozessoren der AMD EPYC™ 9005-Serie können die Integer Performance bestehender Hardware mit bis zu 86 % weniger Racks erreichen [3] und bis zum 3-fachen Durchsatz des maschinellen Lernens von 64-Core Intel Xeon 8592+-Prozessoren bieten [4]. Verschlüsselung auf Hardware-Ebene, wie z. B. die sichere verschlüsselte Virtualisierung, bedeutet zudem, dass Modelle und Daten während des Trainings oder der Inferenz verschlüsselt bleiben können, damit Daten auch in Umgebungen mit mehreren Mandanten vertraulich bleiben.

Entscheidende Infrastrukturbereiche für die KI-Modernisierung

Durch KI lassen sich Geschäftsergebnisse immer schneller erreichen. Das bedeutet aber auch, dass alle diese Herausforderungen durch eine Reihe zielgerichteter Rechenzentrumsmodernisierungen angegangen werden müssen.

1. Serverkonsolidierung als Tür zur KI-Erweiterung.

Moderne CPUs bieten heute Dutzende, wenn nicht Hunderte von Kernen pro Sockel, wodurch Serverkonsolidierung sowohl Platz- als auch Energieeinsparungen ermöglicht. So kann ein moderner Server bis zu sieben bestehende Rechner ersetzen [1]. Gleichzeitig sind AMD EPYC™ Prozessoren die führende CPU für KI [2], da sie die Integer Performance bestehender Hardware mit bis zu 86 % weniger Racks erreichen [3] und dabei einen bis zu dreifachen Durchsatz für maschinelles Lernen im Vergleich zu 64-Core Intel Xeon 8592+-Prozessoren bieten [4]. Außerdem ermöglicht die nächste Generation von CPU-Architekturen eine höhere Performance pro Watt, wodurch Energieverbrauch und laufende Betriebskosten gesenkt werden. Zusätzlich sorgt die Verschlüsselung auf Hardware-Ebene, beispielsweise durch sichere verschlüsselte Virtualisierung, dafür, dass Modelle und Daten vertraulich bleiben, selbst in Umgebungen mit mehreren Mandanten.

2. Flexible Infrastruktur zur schnelleren KI-Skalierung.

Unternehmen können KI-Erweiterungen vereinfachen, indem sie x86-Architekturen beibehalten (im Gegensatz zu ARM-basierten Optionen), sodass bestehende x86-Anwendungen weiterhin genutzt werden können. Da Deep Learning äußerst datenintensiv ist, erfordert es die parallele Verarbeitung durch GPUs sowie eine höhere Speicherbandbreite. Durch die Kombination der Stärken von CPUs mit der Parallelisierung von GPUs wird es möglich, auch die größten Modelle effizient zu verarbeiten und den wachsenden KI-Anforderungen gerecht zu werden. Dabei entsprechen die AMD Instinct™ MI325X Beschleuniger der Konkurrenz in Bezug auf die achtfache GPU-Trainings-Performance [5] und erreichen gleichzeitig eine bis zu viermal höhere Inferenz-Performance [6].

3. Mehr Netzwerkeffizienz und optimierte Verwaltung.

Hoher Durchsatz und performance-sensible KI-Workloads setzen Rechenzentrumsnetzwerke unter erheblichen Druck, weshalb Netzwerkschnittstellenkarten (NICs) und Datenverarbeitungseinheiten (DPUs) entscheidend sind, um diesen Druck vom Backend-Netzwerk zu nehmen. DPUs können dank programmierbarer Kerne Netzwerke, Sicherheitsfunktionen oder Speicherdienste ausführen und dadurch die CPU-Auslastung deutlich reduzieren. So bietet die AMD Pensando™ Salina 400 DPU im Vergleich zu vorhergehenden Generationen den doppelten Wert in Bezug auf Bandbreite, Verbindungen pro Sekunde, Pakete pro Sekunde und Speichervorgänge [7].

4. KI über das Rechenzentrum hinaus.

KI ist längst nicht mehr auf Server beschränkt; KI-PCs bieten Endbenutzern zahlreiche alltägliche Geschäftsvorteile, da sie Daten lokal statt in Cloud-Ressourcen verarbeiten. Dadurch wird Echtzeit-Performance ermöglicht, selbst bei suboptimalen Netzwerkverbindungen, und gleichzeitig bleiben persönliche oder sensible Daten auf dem Gerät, was den Datenschutz erheblich verbessert. Die Prozessoren der AMD Ryzen™ AI 300 Serie führen das KI-PC-Zeitalter an. Diese Systeme sind heute in Microsoft Copilot+ PC-Laptops verfügbar und liefern im Vergleich zu Konkurrenzprodukten eine bis zu 1,4-fache Multithread-Performance [8].

AMD RYZEN™ Prozessoren führen das KI-Zeitalter an

Prozessoren der AMD Ryzen™ AI 300 Serie unterstützen Hunderte verschiedener KI-Erlebnisse und sind heute in einer Vielzahl von Microsoft Copilot+ PC-Laptops verfügbar. Diese Systeme bieten im Vergleich zu Konkurrenzprodukten eine bis zu 1,4-fache Multithread- Performance [8] und bis zu 23 Stunden Akkulaufzeit für mehrere Tage. [9]

Fazit: Nachhaltiger Erfolg mit AMD

Das End-to-End-Portfolio von AMD bietet Unternehmen eine Möglichkeit, die Skalierung voranzutreiben und die Zeit bis zu den Ergebnissen durch die KI-Einführung deutlich zu verkürzen. Gleichzeitig ermöglicht die herausragende Performance pro Watt der AMD EPYC CPUs eine präzise Kontrolle über die laufenden Betriebskosten. Dadurch werden Platzbedarf, Energieverbrauch und Lizenzkosten reduziert, was zu nachhaltigem Erfolg führt. Darüber hinaus unterstützt AMD ein offenes Ökosystem, das Unternehmenspartnern dabei hilft, mit der schnellen Entwicklung der KI-Landschaft Schritt zu halten. Durch die Partnerschaft mit AMD können Unternehmenskunden mit einem stabilen Technologieleader zusammenarbeiten, der kontinuierlich in Forschung und Entwicklung investiert und eine lange Tradition zuverlässiger Produktbereitstellung vorweisen kann. So können Unternehmen mit KI zuversichtlich planen und skalierbaren, nachhaltigen Erfolg [10] erzielen.

Marco Matthias Marcone

Head of Marketing, RNT Rausch GmbH

Ihre KI. Ihr Server. Ihre Kontrolle.

Stellen Sie sich vor, Ihre KI arbeitet schneller, sicherer und völlig unabhängig – direkt in Ihrem eigenen Netzwerk. Keine Cloud. Keine Datenlecks. Keine Wartezeiten.

Die Implementierung einer eigenen KI war noch nie so einfach: Mit Yeren® Local AI starten Sie in die Zukunft der intelligenten Automatisierung – DSGVO-konform, Made in Europe und jetzt zum exklusiven Sonderpreis.

Leistungsbezogene Angaben

1.

9xx5TCO-002A: Dieses Szenario fußt auf vielen Annahmen und Schätzungen, und obwohl es auf internen Forschungen und bestmöglichen Näherungswerten von AMD basiert, dient es nur als Beispiel zur Veranschaulichung und sollte nicht als Grundlage für die Entscheidungsfindung anstelle tatsächlicher Tests dienen. Das AMD Server and Greenhouse Gas Emissions TCO (Total Cost of Ownership) Estimator Tool – Version 1.12 – vergleicht die benötigten AMD EPYC™ und Intel® Xeon® CPU-basierten Server für insgesamt 391000 Einheiten von SPECrate2017_int_base-Performance (Stand 10. Oktober 2024). Bei dieser Schätzung wird ein älterer 2P-Server mit Intel Xeon Platinum_8280 mit 28 Kernen mit einer Bewertung von 391 verglichen mit einem 2P-Server mit EPYC 9965 (192 Kerne) und einer Bewertung von 3000 (https://www.spec.org/cpu2017/results/res2024q4/cpu2017-20240923-44837.pdf) sowie mit einem Vergleichs-Upgrade auf einen 2P-Server mit Intel Xeon Platinum 8592+ (64 Kerne) mit einer Bewertung von 1130 (https://spec.org/cpu2017/results/res2024q3/cpu2017-20240701-43948.pdf). Die tatsächliche SPECrate®2017_int_base-Bewertung für 2P EPYC 9965 kann je nach OEM-Veröffentlichung abweichen. Schätzungen der Umweltauswirkungen auf der Grundlage dieser Daten unter Verwendung der länder- und regionenspezifischen Stromfaktoren aus „2024 International Country Specific Electricity Factors 10 – July 2024“ und „Greenhouse Gas Equivalencies Calculator“ der United States Environmental Protection Agency. Weitere Details unter https://www.amd.com/en/legal/claims/epyc.html#q=SP9xxTCO-002A.

2.

9xx5-012: TPCxAI @SF30 Multi-Instanz mit 32 Kernen Instanzgröße-Durchsatzergebnisse basierend auf internen Tests von AMD vom 05.09.2024 bei Ausführung mehrerer VM-Instanzen. Der aggregierte durchgängige KI-Durchsatztest ist vom TPCx-AI-Benchmark abgeleitet und als solcher nicht mit den veröffentlichten TPCx-AI-Ergebnissen vergleichbar, da die Ergebnisse des durchgängigen KI-Durchsatztests nicht der TPCx-AI-Spezifikation entsprechen. 2P AMD EPYC 9965 (384 Kerne gesamt), 12 Instanzen mit 32 Kernen, NPS1, 1,5 TB 24 x 64 GB DDR5- 6400 (bei 6000 MT/s), 1DPC, 1,0 Gbit/s NetXtreme BCM5720 Gigabit Ethernet PCIe, 3,5 TB Samsung MZWLO3T8HCLS-00A07 NVMe®, Ubuntu® 22.04.4 LTS, 6.8.0-40-generic (tuned-adm profile throughputperformance, ulimit -l 198096812, ulimit -n 1024, ulimit -s 8192), BIOS RVOT1000C (SMT = off, Determinism = Power, Turbo Boost = Enabled) 2P AMD EPYC 9755 (256 Kerne gesamt), 8 Instanzen mit 32 Kernen, NPS1, 1,5 TB 24 x 64 GB DDR5- 6400 (bei 6000 MT/s), 1DPC, 1,0 Gbit/s NetXtreme BCM5720 Gigabit Ethernet PCIe, 3,5 TB Samsung MZWLO3T8HCLS-00A07 NVMe®, Ubuntu 22.04.4 LTS, 6.8.0-40-generic (tuned-adm profile throughputperformance, ulimit -l 198096812, ulimit -n 1024, ulimit -s 8192), BIOS RVOT0090F (SMT = off, Determinism = Power, Turbo Boost = Enabled) 2P AMD EPYC 9654 (192 Kerne gesamt), 6 Instanzen mit 32 Kernen, NPS1, 1,5 TB 24 x 64 GB DDR5-4800, 1DPC, 2 x 1,92 TB Samsung MZQL21T9HCJR-00A07 NVMe, Ubuntu 22.04.3 LTS, BIOS 1006C (SMT = off, Determinism = Power) Im Vergleich zu 2P Xeon Platinum 8592+ (128 Kerne gesamt), 4 Instanzen mit 32 Kernen, AMX Ein, 1 TB 16 x 64 GB DDR5-5600, 1DPC, 1,0 Gbit/s NetXtreme BCM5719 Gigabit Ethernet PCIe, 3,84 TB KIOXIA KCMYXRUG3T84 NVMe, Ubuntu 22.04.4 LTS, 6.5.0-35 generic (tuned-adm profile throughputperformance, ulimit -l 132065548, ulimit -n 1024, ulimit -s 8192), BIOS ESE122V (SMT = off, Determinism = Power, Turbo Boost = Enabled) Ergebnisse: CPU Medianwert Relativer Wert Generationenvergleich Turin 192 Kerne, 12 Instanzen 6067,531 3,775 2,278 Turin 128 Kerne, 8 Instanzen 4091,85 2,546 1,536 Genoa 96 Kerne, 6 Instanzen 2663,14 1,657 1 EMR 64 Kerne, 4 Instanzen 1607,417 1 NA Die Ergebnisse können abhängig von Faktoren wie Systemkonfiguration, Softwareversion und BIOSEinstellungen variieren. TPC, TPC Benchmark und TPC-C sind Marken des Transaction Processing Performance Council.

3.

9xx5TCO-001B: Dieses Szenario fußt auf vielen Annahmen und Schätzungen, und obwohl es auf internen Forschungen und bestmöglichen Näherungswerten von AMD basiert, dient es nur als Beispiel zur Veranschaulichung und sollte nicht als Grundlage für die Entscheidungsfindung anstelle tatsächlicher Tests dienen. Das AMD Server and Greenhouse Gas Emissions TCO (Total Cost of Ownership) Estimator Tool – Version 1.12 – vergleicht die benötigten AMD EPYC™ und Intel® Xeon® CPU-basierten Server für insgesamt 39.100 Einheiten von SPECrate2017_int_base-Performance (Stand 10. Oktober 2024). Bei dieser Schätzung wird ein älterer 2P-Server mit Intel Xeon Platinum_8280 mit 28 Kernen mit einer Bewertung von 391 verglichen mit einem 2P-Server mit EPYC 9965 (192 Kerne) und einer Bewertung von 3000 (https://www.spec.org/cpu2017/results/res2024q4/cpu2017-20240923-44837.pdf) sowie mit einem Vergleichs-Upgrade auf einen 2P-Server mit Intel Xeon Platinum 8592+ (64 Kerne) mit einer Bewertung von 1130 (https://spec.org/cpu2017/results/res2024q3/cpu2017-20240701-43948.pdf). Die tatsächliche SPECrate®2017_int_base-Bewertung für 2P EPYC 9965 kann je nach OEM-Veröffentlichung abweichen. Schätzungen der Umweltauswirkungen auf der Grundlage dieser Daten unter Verwendung der länder- und regionenspezifischen Stromfaktoren aus „2024 International Country Specific Electricity Factors 10 – July 2024“ und „Greenhouse Gas Equivalencies Calculator“ der United States Environmental Protection Agency.

4.

9xx5-040A: XGBoost (Läufe/Stunde) Durchsatzergebnisse basierend auf internen Tests von AMD vom 05.09.2024. XGBoost Konfigurationen: v2.2.1, Higgs Data Set, Instanzen mit 32 Kernen, FP32 2P AMD EPYC 9965 (384 Kerne gesamt), Instanzen mit 12 x 32 Kernen, 1,5 TB 24 x 64 GB DDR5-6400 (bei 6000 MT/s), 1,0 Gbit/s NetXtreme BCM5720 Gigabit Ethernet PCIe, 3,5 TB Samsung MZWLO3T8HCLS- 00A07 NVMe®, Ubuntu® 22.04.4 LTS, 6.8.0-45-generic (tuned-adm profile throughput-performance, ulimit -l 198078840, ulimit -n 1024, ulimit -s 8192), BIOS RVOT1000C (SMT = off, Determinism = Power, Turbo Boost = Enabled), NPS = 1 2P AMD EPYC 9755 (256 Kerne gesamt), 1,5 TB 24 x 64 GB DDR5-6400 (bei 6000 MT/s), 1 DPC, 1,0 Gbit/s NetXtreme BCM5720 Gigabit Ethernet PCIe, 3,5 TB Samsung MZWLO3T8HCLS-00A07 NVMe®, Ubuntu 22.04.4 LTS, 6.8.0-40-generic (tuned-adm profile throughput-performance, ulimit -l 198094956, ulimit -n 1024, ulimit -s 8192), BIOS RVOT0090F (SMT = off, Determinism = Power, Turbo Boost = Enabled), NPS = 1 2P AMD EPYC 9654 (192 Kerne gesamt), 1,5 TB 24 x 64 GB DDR5-4800, 1 DPC, 2 x 1,92 TB Samsung MZQL21T9HCJR-00A07 NVMe®, Ubuntu 22.04.4 LTS, 6.8.0-40-generic (tuned-adm profile throughputperformance, ulimit -l 198120988, ulimit -n 1024, ulimit -s 8192), BIOS TTI100BA (SMT = off, Determinism = Power), NPS = 1 im Vergleich zu 2P Xeon Platinum 8592+ (128 Kerne gesamt), AMX Ein, 1 TB 16 x 64 GB DDR5-5600, 1 DPC, 1,0 Gbit/s NetXtreme BCM5719 Gigabit Ethernet PCIe, 3,84 TB KIOXIA KCMYXRUG3T84 NVMe®, Ubuntu 22.04.4 LTS, 6.5.0-35 generic (tuned-adm profile throughput-performance, ulimit -l 132065548, ulimit -n 1024, ulimit -s 8192), BIOS ESE122V (SMT = off, Determinism = Power, Turbo Boost = Enabled) Ergebnisse: CPU Lauf 1 Lauf 2 Lauf 3 Medianwert Relativer Wert Durchsatz Generationenvergleich 2P Turin 192 Kerne, NPS1 1565,217 1537,367 1553,957 1553,957 3 2,41 2P Turin 128C, NPS1 1103,448 1138,34 1111,969 1111,969 2,147 1,725 2P Genoa 96C, NPS1 662,577 644,776 640,95 644,776 1,245 1 2P EMR 64C 517,986 421,053 553,846 517,986 1 NA Die Ergebnisse können abhängig von Faktoren wie Systemkonfiguration, Softwareversion und BIOSEinstellungen variieren.

5.

MI325-012: Gesamt-GPU-normalisierter Trainingsdurchsatz (verarbeitete Token pro Sekunde) für die Textgenerierung unter Verwendung des Chat-Modells Llama2-7b mit Megatron-LM v0.12 (BF16) bei Verwendung einer maximalen Sequenzlänge von 4.096 Token, Vergleich basiert auf internen Tests von AMD vom 04.10.2024. Batchgröße gemäß dem größten Micro-Batch, der in den GPU-Speicher jedes Systems passt. AMD Instinct Batchgröße 8, Nvidia Batchgröße 2. Konfigurationen: AMD Entwicklungssystem: 1P AMD Ryzen 9 7950X (16 Kerne), 1 x AMD Instinct™ MI325X (256 GB, 1000 W) GPU, 128 GiB Speicher, ROCm 6.3.0 (Pre-Release), Ubuntu 22.04.2 LTS mit Linux-Kernel 5.15.0-72-generic, PyTorch 2.4.0. im Vergleich zu Nvidia DGX H200 mit 2 x Intel Xeon Platinum 8468 Prozessoren, 1 x Nvidia H200 (141 GB, 700 W) GPU, 2 TiB (32 DIMMs, 64 GiB/DIMM), CUDA 12.6.37-1, 560.35.03, Ubuntu 22.04.5, PyTorch 2.5.0a0+872d972e41. nv24.8. MI325X-System Median 12509,82 Token/Sekunde/GPU H200-System Median 11824,09 Token/Sekunde/GPU Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI325-012

6.

MI325-004: Basierend auf Tests, die am 28.09.2024 vom AMD Leistungslabor durchgeführt wurden, bei denen der Durchsatz von generiertem Text für das Modell Mixtral-8x7B unter Verwendung des Datentyps FP16 gemessen wurde. Der Test wurde mit einer Eingabelänge von 128 Token und einer Ausgabelänge von 4.096 Token für die folgenden Konfigurationen des AMD Instinct™ MI325X GPU-Beschleunigers und des NVIDIA H200 SXM GPU-Beschleunigers durchgeführt. 1 x MI325X bei 1000 W mit vLLM-Performance: 4.598 (Eingabe-Token/s) im Vergleich zu 1 x H200 bei 700 W mit TensorRT-LLM: 2.700,7 (Eingabe-Token/s) Konfigurationen: AMD Instinct™ MI325X Referenzplattform: 1 x AMD Ryzen™ 9 7950X CPU, 1 x AMD Instinct MI325X (256 GiB, 1000 W) GPU, Ubuntu® 22.04 und ROCm™ 6.3 Pre-Release im Vergleich zur NVIDIA H200 HGX Plattform: Supermicro SuperServer mit 2 x Intel Xeon® Platinum 8468 Prozessoren, 8 x Nvidia H200 GPUs (140 GB, 700 W) [in diesem Test wurde nur 1 GPU verwendet], Ubuntu 22.04, CUDA® 12.6. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren.

7.

PEN-012: Messungen durchgeführt im AMD Leistungslabor am 27. August 2024 anhand der aktuellen Spezifikation für den AMD Pensando™ Salina DPU-Beschleuniger, konzipiert mit AMD Pensando™ 5-nm- Prozesstechnologie, die zu einer geschätzten linearen Performance von 400 Gb/s führen soll. Geschätzte gelieferte Ergebnisse berechnet für AMD Pensando™ Elba DPU mit AMD Pensando 7-nm- Prozesstechnologie ergaben eine lineare Performance von 200 Gb/s. Die tatsächlichen Ergebnisse auf Basis von Chips aus der Produktion können abweichen. Geschätzte Salina-Performance: Bandbreite: 400 Gb/s Verbindungen pro Sekunde: 10 Mio. Pakete pro Sekunde: 100 Mpps Verschlüsselungs-Offloads: 400 Gb/s Speicher-IOPS: 4 Millionen Die tatsächlichen Ergebnisse auf Basis von Chips aus der Produktion können abweichen.

8.

STXP-12: Tests durchgeführt im AMD Leistungslabor im September 2024 auf einem HP EliteBook X G1a (14 Zoll, 40 W) mit einem AMD Ryzen AI 9 HX PRO 375 Prozessor, Radeon™ 890M Grafikeinheit, 32 GB RAM, 512 GB SSD, VBS=EIN, Windows 11 Pro im Vergleich zu einem Dell Latitude 7450 mit Intel Core Ultra 7 165H Prozessor (vPro aktiviert), Intel Arc Grafikkarte, VBS=EIN, 16 GB RAM, 512 GB NVMe SSD, Microsoft Windows 11 Pro in der Anwendung (im Modus „Beste Performance“): Cinebench R24 nT. Hersteller von Notebooks können unterschiedliche Konfigurationen verwenden, was zu unterschiedlichen Ergebnissen führt. STXP-12

9.

STXP-32: Basierend auf internen Tests von AMD mit Stand 23.09.2024. Akkulaufzeit-Ergebnisse gemessen in Microsoft Teams-Videokonferenz mit neun Teilnehmern im Akkubetrieb. Testkonfiguration für AMD und Intel Systeme läuft im Modus „Beste Energieeffizienz“, eingestellt auf 90 % > 45 % Leistung bei 150 cd/m² Helligkeit. Systemkonfig.: HP EliteBook X G1a (14 Zoll) mit einem AMD Ryzen AI 9 HX PRO 375 Prozessor (40 W), Radeon™ 890M Grafikeinheit, 32 GB RAM, 512 GB SSD, VBS=EIN, Windows 11 Pro. Systemkonfig.: Apple MacBook Pro 14 mit M3 Pro 12-Core Prozessor, integrierter Apple Grafikeinheit, 36 GB RAM, 1 TB SSD, macOS 15.0. Systemkonfig.: Dell Latitude 7450 mit einem Intel Core Ultra 7 165H Prozessor (28 W) (vPro aktiviert), Intel Arc Grafikeinheit, VBS=EIN, 16 GB RAM, 512 GB NVMe SSD, Windows 11 Pro. Hersteller wählen ggf. andere Konfigurationen, sodass die Ergebnisse abweichen können. Performance kann auch abhängig von der Verwendung neuester Treiber abweichen. STXP-32

10.

9xx5TCO-001C: Dieses Szenario fußt auf vielen Annahmen und Schätzungen, und obwohl es auf internen Forschungen und bestmöglichen Näherungswerten von AMD basiert, dient es nur als Beispiel zur Veranschaulichung und sollte nicht als Grundlage für die Entscheidungsfindung anstelle tatsächlicher Tests dienen. Das AMD Server and Greenhouse Gas Emissions TCO (Total Cost of Ownership) Estimator Tool – Version 1.12 – vergleicht die benötigten AMD EPYC™ und Intel® Xeon® CPU-basierten Server für insgesamt 39.100 Einheiten von SPECrate2017_int_base-Performance (Stand 10. Oktober 2024). Bei dieser Schätzung wird ein älterer 2P-Server mit Intel Xeon Platinum_8280 mit 28 Kernen mit einer Bewertung von 391 verglichen mit einem 2P-Server mit EPYC 9965 (192 Kerne) und einer Bewertung von 3000 (https://www.spec.org/cpu2017/results/res2024q4/cpu2017-20240923-44837.pdf) sowie mit einem Vergleichs-Upgrade auf einen 2P-Server mit Intel Xeon Platinum 8592+ (64 Kerne) mit einer Bewertung von 1130 (https://spec.org/cpu2017/results/res2024q3/cpu2017-20240701-43948.pdf). Die tatsächliche SPECrate®2017_int_base-Bewertung für 2P EPYC 9965 kann je nach OEM-Veröffentlichung abweichen. Schätzungen der Umweltauswirkungen auf der Grundlage dieser Daten unter Verwendung der länderund regionenspezifischen Stromfaktoren aus „2024 International Country Specific Electricity Factors 10 – July 2024“ und „Greenhouse Gas Equivalencies Calculator“ der United States Environmental Protection Agency. Weitere Details unter https://www.amd.com/en/legal/claims/epyc.html#q=epyc5#9xx5TCO-001B

Andere Nutzer haben auch folgende Artikel gelesen

NIS2 leicht gemacht: Wie unveränderbarer Speicher zur Compliance beiträgt

Die neue NIS2-Richtlinie stellt Unternehmen vor die Herausforderung, ihre Cybersicherheitsmaßnahmen zu verstärken und ihre Datenintegrität zu gewährleisten. Mit unveränderbarem Speicher (Immutable Storage) können sie sicherstellen, dass kritische Daten dauerhaft geschützt sind und nicht manipuliert werden können. Diese Technologie bietet nicht nur erhöhte Sicherheit, sondern erfüllt auch die strengen Anforderungen der NIS2.

Entdecken Sie, wie Immutable Storage auch Ihr Unternehmen bei der Einhaltung der Richtlinie unterstützt und gleichzeitig Ihre sensiblen Informationen absichert.

Big Data Management im Mittelstand

Was für Großunternehmen mit umfassenden Datensammlungen aus Artificial…

Wie moderne Hardware

KI-Infrastrukturen revolutioniert

Moderne KI-Infrastrukturen profitieren enorm von der perfekt abgestimmten…

Edge Computing im digitalen Gesundheitswesen

Der digitale Austausch von Gesundheitsdaten rettet Leben. Wenn alle an einer…

Das Recht auf Reparatur – Längere Nutzung, weniger Elektroschrott

In der Gesellschaft regt sich (endlich) Widerstand gegen die Wegwerfwirtschaft.…

MACH.2 Multi-Actuator Festplatten – Fast so schnell wie SSDs, aber viel preiswerter

Sie gelten als die schnellsten Festplatten der Welt, weil sie fast die…

Kühlmethoden für Rechenzentren:

Liquid Cooling vs Immersion Cooling

Kühlung neu gedacht: In Zeiten von KI und HPC stoßen klassische Lüfter an ihre…