Von cloud-nativer Innovation zum Unternehmensstandard: Der Aufstieg der S3-API als zentrale Speicherlösung

Als Amazon Web Services (AWS) 2006 den Simple Storage Service (S3) einführte, leitete dies einen bahnbrechenden Wandel in der Art und Weise ein, wie Daten gespeichert, abgerufen und verwaltet werden. Ursprünglich als Nischenangebot für cloud-native Workloads betrachtet, hat sich die S3-API mittlerweile zur branchenüblichen Schnittstelle für Object Storage entwickelt. Heute steht sie als robuste, hoch skalierbare und kosteneffiziente Speicherlösung da, die zunehmend nicht nur in der Public Cloud, sondern auch in hybriden IT-Infrastrukturen und sogar in On-Premises-Umgebungen von Unternehmen eingesetzt wird.

Der anhaltende Reiz der S3-API liegt in ihrer Einfachheit, Skalierbarkeit und plattformunabhängigen Architektur. Durch die Abstraktion der Komplexität der zugrunde liegenden Infrastruktur und die Ermöglichung des HTTP-basierten Zugriffs auf Objekte in Buckets erlaubt sie eine mühelose Integration über eine Vielzahl von Softwareplattformen und Unternehmensanwendungen hinweg. Dazu gehören Backup- und Archivierungslösungen, Medienarchive, Data Lakes und Analyseplattformen.

Dank ihrer zustandslosen, RESTful Architektur ist die S3-API ideal für verteilte Workloads, DevOps-Umgebungen und cloud-native Anwendungen geeignet. Darüber hinaus stellt ein umfassendes Ökosystem aus Tools, SDKs und Drittanbieter-Integrationen sicher, dass sie hochgradig zugänglich und entwicklerfreundlich bleibt.

Datenwachstum erfordert skalierbare Speicherlösungen

Die Nachfrage nach skalierbaren, flexiblen Speicherlösungen war noch nie so wichtig. Die globalen Datenmengen verdoppeln sich weiterhin alle paar Jahre, bedingt durch den schnellen Anstieg von maschinell erzeugten Daten, AI-Trainingsdatensätzen, Überwachungsaufnahmen und Anforderungen an die Einhaltung von Vorschriften.

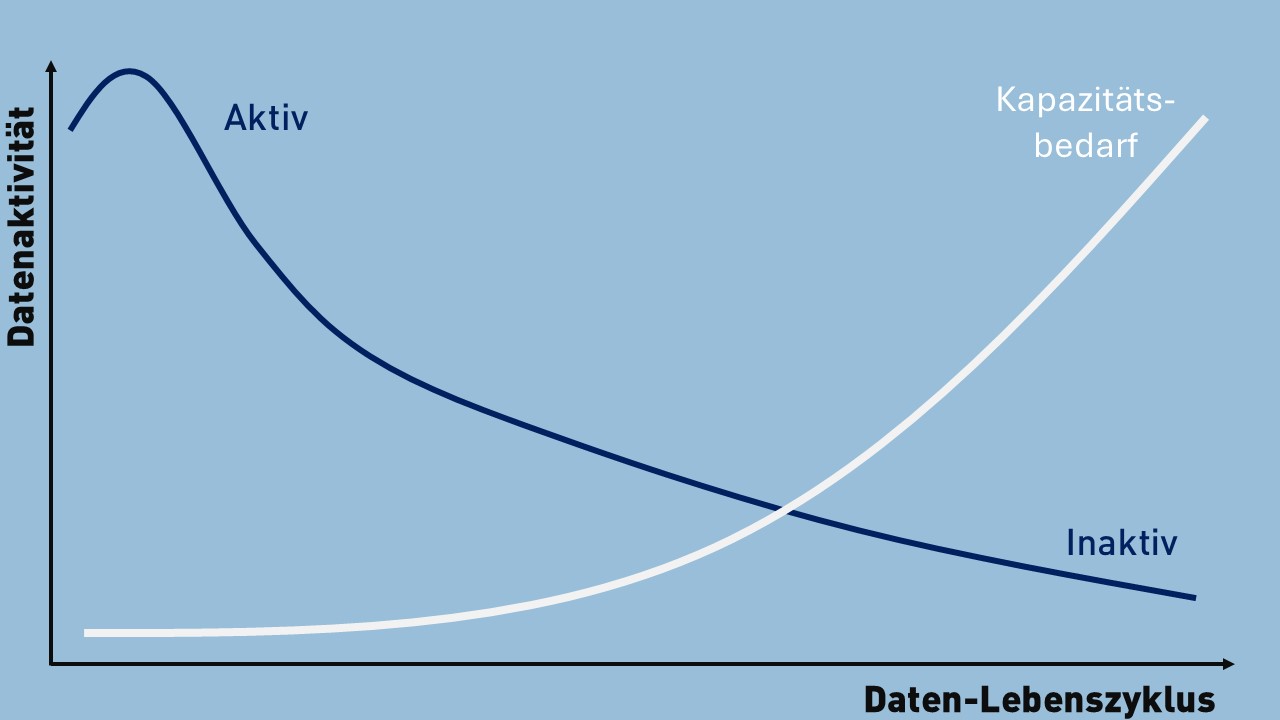

Trotz dieses explosionsartigen Anstiegs der Datenerstellung wird jedoch nur geschätzt, dass 10 bis 20 Prozent der gespeicherten Informationen zu einem bestimmten Zeitpunkt aktiv genutzt werden. Darüber hinaus hat sich das Zeitfenster, in dem Daten „heiß“ oder häufig abgerufen werden, dramatisch verkürzt – in vielen Fällen von Monaten oder Jahren auf nur noch Tage oder Wochen.

Dieses sich entwickelnde Muster unterstreicht die Bedeutung von tiered Storage-Architekturen. Unternehmen müssen in der Lage sein, zwischen wertvollen, zeitkritischen Daten und langfristig, selten abgerufenen Informationen zu unterscheiden. Während „heiße“ Daten schnellen, latenzarmen Zugriff erfordern, kann die Mehrheit der Daten effizient mit robusten, kostengünstigen Object-Storage-Lösungen wie S3-kompatiblen Plattformen gespeichert werden, die speziell für „kalte“ oder inaktive Daten entwickelt wurden.

80 % Ihrer Daten sind inaktiv

Da der Großteil der Unternehmensdaten heute als inaktiv oder „kalt“ gilt, aber dennoch aufbewahrt, geschützt und jederzeit abrufbar sein muss, sind Organisationen gezwungen, traditionelle Hochleistungs-Speichermodelle neu zu überdenken. Der Einsatz teurer, latenzarmer Speichersysteme für große Mengen an wenig abgerufenen Daten wird zunehmend wirtschaftlich untragbar, insbesondere angesichts des explosiven Datenwachstums.

Die wachsende Nutzung von S3-kompatiblem Object Storage bietet eine überzeugende Alternative – aber sie wirft auch eine entscheidende Frage für IT-Entscheider auf:

Wie schneidet S3-kompatibler Storage im Vergleich zu traditionellen Block-Level-Speichersystemen ab – diesen Hochleistungs-, latenzarmen Plattformen, die lange Zeit das Fundament kritischer IT-Infrastrukturen bildeten?

Darum erobert S3-Speicher Rechenzentren

- Skalierbarkeit

Nahezu unbegrenzte Speicherkapazität mit horizontaler Skalierbarkeit, die es Organisationen ermöglicht, nach Bedarf zu erweitern – ohne Ausfallzeiten oder Störungen. - Kosten-Effizienz

Optimiert für kapazitätsbasierte Preisgestaltung unterstützt S3-kompatibler Storage gestufte Speichermodelle (hot, cold, archive), um Kosten basierend auf den Datenzugriffsmustern zu optimieren. - Einfachheit und Flexibilität

Ermöglicht Self-Service-Bereitstellung und API-gesteuerten Zugriff, was die Integration über verschiedene Workloads und Plattformen hinweg erleichtert. - Resilienz und Haltbarkeit

Stellt hohe Datenverfügbarkeit und Integrität durch eingebaute Redundanz, Replikation oder Erasure-Coding sicher – auch auf Petabyte-Ebene. - Multi-Tenancy und Unternehmenssicherheit

Bietet fein abgestufte Zugriffskontrollen, serverseitige Verschlüsselung und Audit-Logging, die sichere, Multi-Tenant-Umgebungen unterstützen. - Cloud-native Integration

Integriert sich nahtlos mit Cloud-Plattformen, modernen Anwendungsframeworks und DevOps-Pipelines und unterstützt eine Vielzahl von hybriden und cloud-nativen Architekturen.

Achtugn: Wenn S3 an seine Grenzen stößt!

- Latenz- und Leistungsbeschränkungen

S3-kompatibler Object Storage ist nicht für hohe IOPS oder latenzkritische Transaktions-Workloads ausgelegt, weshalb er sich nicht für Datenbanken oder Echtzeitverarbeitungsaufgaben eignet. - Konsistenzmodelle

Viele Object-Storage-Plattformen arbeiten mit Eventual Consistency, was Herausforderungen für Anwendungen mit strengen Anforderungen an Transaktionsintegrität und sofortige Konsistenz darstellen kann. - Protokoll-Overhead

Der Zugriff auf Daten über HTTP/S-Protokolle führt zu Latenz und Verarbeitungsaufwand, insbesondere im Vergleich zu direkt angeschlossenen oder SAN-basierten Blockspeichersystemen. - Kompatibilität mit Legacy-Anwendungen

Traditionelle Unternehmensanwendungen – insbesondere solche, die auf Datei- oder Blockspeicher-Paradigmen basieren – benötigen möglicherweise umfangreiche Umstellungen oder Middleware-Lösungen, um effektiv mit den S3-APIs zu interagieren.

Block Storage hat nach wie vor seine Berechtigung

Block-Level-Speicher bleibt die bevorzugte Wahl für Datenbanken, Virtualisierungsplattformen und latenzempfindliche Workloads. Mit garantierten Leistungskennzahlen (QoS), umfangreicher RAID-Funktionalität und nachgewiesener Integration in bestehende IT-Landschaften erfüllt Block-Speicher weiterhin eine entscheidende Rolle in vielen Unternehmensarchitekturen. Aber die eigentliche Frage ist: Für welchen Zweck und zu welchem Preis?

Die Architektur von S3-kompatiblem Speicher führt jedoch ein zukunftssicheres Paradigma ein, besonders für die 80-90 % der Daten, die inaktiv, aber dennoch geschäftskritisch sind, während das Datenvolumen und die Verarbeitungsanforderungen wachsen. Im Gegensatz zu traditionellem Block-Speicher, der auf einen zentralisierten Controller und eng gekoppelte Infrastruktur angewiesen ist, nutzt S3 parallele Speicherverarbeitung und zustandslose Interaktionen. Dies ermöglicht es Clients, Daten gleichzeitig über verteilte Knoten zu lesen und zu schreiben und beseitigt die typischen I/O-Flaschenhälse monolithischer Systeme.

Darüber hinaus verschiebt sich die Intelligenz zunehmend auf die Client-Seite: Moderne Anwendungen und Backup-Lösungen sind immer häufiger in der Lage, Aufgaben wie Chunking, Deduplizierung und Retry-Logik unabhängig zu übernehmen. Diese architektonische Trennung von Daten- und Steuerungsebenen ermöglicht eine unübertroffene Skalierbarkeit und Flexibilität, wodurch S3-basierter Speicher von Natur aus anpassungsfähiger für cloud-native, KI-gesteuerte und datenintensive Workloads der Zukunft ist.

Kontinuierlicher Schutz auf Objekt-Ebene

Ein weiterer entscheidender Vorteil von S3-kompatiblem Speicher liegt in der Art und Weise, wie er den Datenschutz handhabt. Traditionelle SAN-Systeme sind stark auf geplante Snapshots auf Volumenebene angewiesen, die den gesamten Datensatz zu einem bestimmten Zeitpunkt erfassen. Obwohl effektiv, führt dieses Modell zu Lücken zwischen den Snapshots und fehlt an Granularität—das Wiederherstellen einer einzelnen Datei bedeutet oft, dass ein ganzes Volumen wiederhergestellt oder komplexe Backup-Sets navigiert werden müssen. Im Gegensatz dazu bietet S3-Speicher integrierte Versionierung und Aufbewahrungsrichtlinien für jedes Objekt.

Jedes Objekt kann mehrere historische Versionen automatisch speichern, was echten kontinuierlichen Datenschutz ermöglicht. In Kombination mit Object-Lock-Funktionen wird dies zu einer Compliance-gerechten Unveränderbarkeit und einer Wiederherstellung auf Dateiebene, wodurch das Risiko von Datenverlusten drastisch reduziert und die Wiederherstellungszeiten erheblich verbessert werden. Es ist ein Modell, das viel besser für die heutigen Echtzeit-, hochvolumigen und compliance-sensiblen Umgebungen geeignet ist.

Fazit

Mit dem wachsenden Datenvolumen und der Weiterentwicklung der Anwendungsarchitekturen werden die Einschränkungen traditioneller Speicherlösungen immer deutlicher. S3-kompatibler Object Storage hat sich als mehr als nur eine cloud-native Bequemlichkeit erwiesen – er ist eine skalierbare, flexible und kosteneffiziente Grundlage für modernes Datenmanagement. Vom granularem Schutz auf Objektebene bis hin zu Client-seitiger Intelligenz und parallelen Zugriffsmodellen passt S3 perfekt zu den Anforderungen von Echtzeit-Analyse, Compliance und Hybrid-Cloud-Strategien. Während traditioneller Block-Speicher nach wie vor eine entscheidende Rolle in latenzempfindlichen Workloads spielt, wird die Zukunft der groß angelegten, nachhaltigen Datenspeicherung zunehmend durch die Stärken der S3-API definiert.

Vincent van der Linden

Regional Sales Manager, RNT Rausch GmbH

Andere Nutzer haben auch folgende Artikel gelesen

NIS2 leicht gemacht: Wie unveränderbarer Speicher zur Compliance beiträgt

Die neue NIS2-Richtlinie stellt Unternehmen vor die Herausforderung, ihre Cybersicherheitsmaßnahmen zu verstärken und ihre Datenintegrität zu gewährleisten. Mit unveränderbarem Speicher (Immutable Storage) können sie sicherstellen, dass kritische Daten dauerhaft geschützt sind und nicht manipuliert werden können. Diese Technologie bietet nicht nur erhöhte Sicherheit, sondern erfüllt auch die strengen Anforderungen der NIS2.

Entdecken Sie, wie Immutable Storage auch Ihr Unternehmen bei der Einhaltung der Richtlinie unterstützt und gleichzeitig Ihre sensiblen Informationen absichert.

Yowie® hat etwas…

Yowie® hat etwas das andere Appliances nicht haben. Ein Blick hinter die…

Object Storage für KI-Anwendungen:

skalierbarer Speicher für datenintensive Workloads

Künstliche Intelligenz braucht Daten – und zwar gigantische Mengen. Doch…

Edge Computing für den Mittelstand – Sinn oder Unsinn?

Es gibt gute Gründe dafür, Workloads in ein kleines Edge-Rechenzentrum zu…

Das Recht auf Reparatur – Längere Nutzung, weniger Elektroschrott

In der Gesellschaft regt sich (endlich) Widerstand gegen die Wegwerfwirtschaft.…

KI erfolgreich einführen:

Herausforderungen verstehen, Chancen nutzen

KI verändert die Unternehmenswelt. Doch wer KI erfolgreich einführen will,…

Individuelle IT-Lösungen für eine zukunftssichere IT-Infrastruktur

Ein "One-Size-Fits-All"-Ansatz funktioniert einfach nicht, wenn Organisationen…